HCIP學習筆記 數據庫服務規劃之數據處理服務詳解

在HCIP(華為認證ICT高級工程師)數據庫服務規劃的學習中,數據處理服務是確保數據價值得以有效釋放的核心環節。它不僅僅是簡單的數據增刪改查,而是一個涵蓋數據采集、轉換、加工、分析和應用的完整服務體系。本文將圍繞數據處理服務的核心概念、關鍵技術和規劃要點進行梳理。

一、數據處理服務的內涵與定位

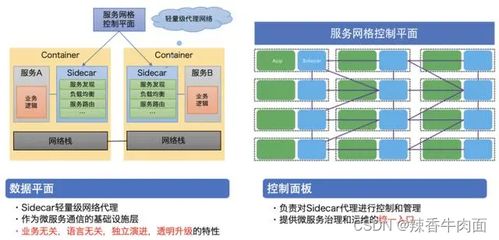

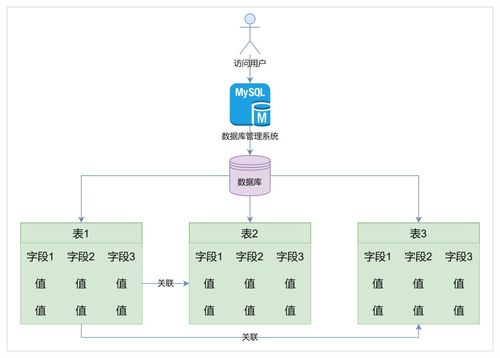

數據處理服務位于數據庫整體架構的“應用層”與“存儲層”之間,其核心目標是將原始數據轉化為可供業務直接使用的信息、知識或服務。在云數據庫或分布式數據庫體系中,它通常以一系列服務化、組件化的形式提供,例如:

- 數據集成服務:負責從異構數據源(如業務數據庫、日志文件、IoT設備)實時或批量抽取數據。

- 數據轉換與清洗服務(ETL/ELT):對數據進行標準化、去重、補全、脫敏等操作,保障數據質量。

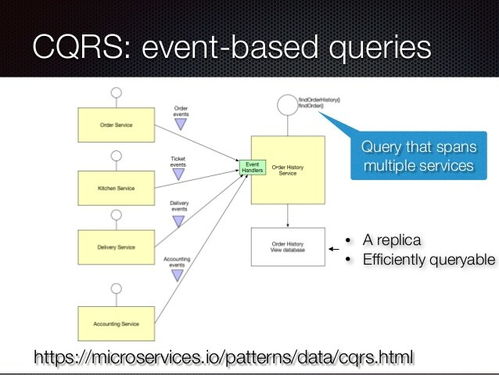

- 數據計算與分析服務:提供批處理(如Spark)、流處理(如Flink)、交互式查詢(如Presto)等計算引擎,執行復雜的業務邏輯與數據分析。

- 數據服務化(Data API):將處理后的數據以API接口的形式安全、高效地暴露給前端應用,實現數據與應用的解耦。

二、關鍵技術組件與架構

規劃數據處理服務時,需重點考量以下技術組件及其選型:

- 計算引擎選擇:

- 批處理場景:適用于T+1報表、歷史數據挖掘。需關注引擎的吞吐量、資源利用率和與存儲系統的兼容性(如Hive on HDFS)。

- 流處理場景:適用于實時監控、實時推薦。需關注引擎的延遲、Exactly-Once語義保障及狀態管理能力。

- 混合處理(Lambda/Kappa架構):結合批流優勢,滿足復雜業務需求。

- 數據流水線編排:采用如Apache Airflow、DolphinScheduler等工具,實現數據處理任務的可視化編排、調度與監控,確保任務依賴關系正確、執行可控。

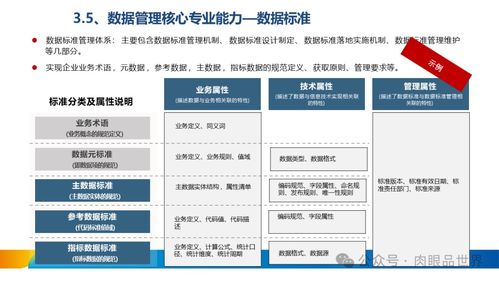

- 數據質量與治理:在數據處理各環節嵌入質量校驗規則(如完整性、一致性檢查),并建立數據血緣追蹤,確保數據處理過程可審計、問題可溯源。

三、核心規劃要點與實踐建議

- 明確處理目標與SLA:首先界定數據處理是服務于實時決策、離線報表還是數據科學探索。不同的目標決定了不同的技術棧與資源投入。必須明確數據處理的延遲、準確性等SLA(服務等級協議)要求。

- 設計可擴展的流水線:數據處理邏輯會隨業務快速變化。規劃時應采用模塊化、低耦合的設計,便于單個環節的獨立更新與擴展。計算與存儲資源應能彈性伸縮,以應對數據量或計算壓力的波動。

- 保障數據安全與合規:在數據處理過程中,尤其是涉及敏感信息時,必須規劃數據脫敏、加密傳輸與存儲、權限精細管控等措施。確保符合GDPR等數據隱私法規要求。

- 監控、運維與成本優化:建立完整的監控指標體系,涵蓋任務執行狀態、數據處理延遲、資源利用率、數據質量波動等。通過監控及時發現故障與性能瓶頸。對計算資源進行精細化管理(如自動啟停、選擇Spot實例),優化運營成本。

四、

數據處理服務是連接數據存儲與業務價值的橋梁。在HCIP的視角下,規劃者需要具備全局思維,不僅要精通各類計算引擎的技術特性,更要深刻理解業務需求,設計出高可靠、高效率、易維護且成本可控的數據處理體系。一個優秀的數據處理服務規劃,能夠使數據資產靈活、穩定地驅動業務創新與智能決策。

(注:本筆記基于華為云數據庫及相關開源技術生態的最佳實踐進行歸納,具體實現需結合實際項目需求與技術選型進行調整。)

如若轉載,請注明出處:http://www.qqtwt.cn/product/66.html

更新時間:2026-02-09 16:15:23